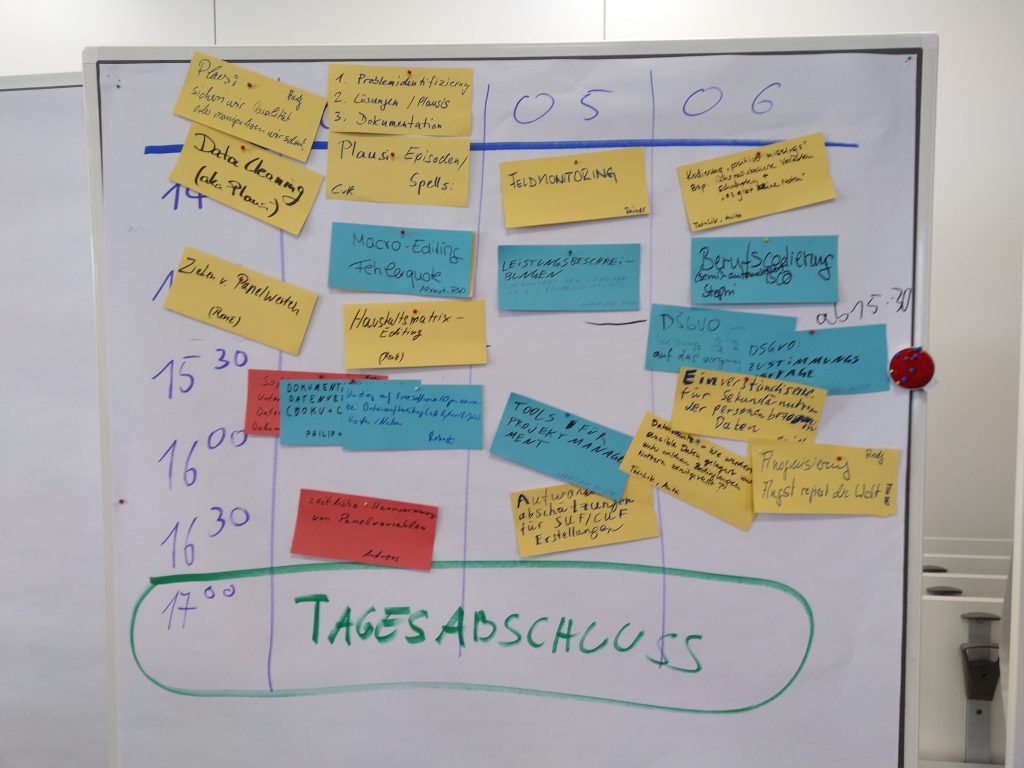

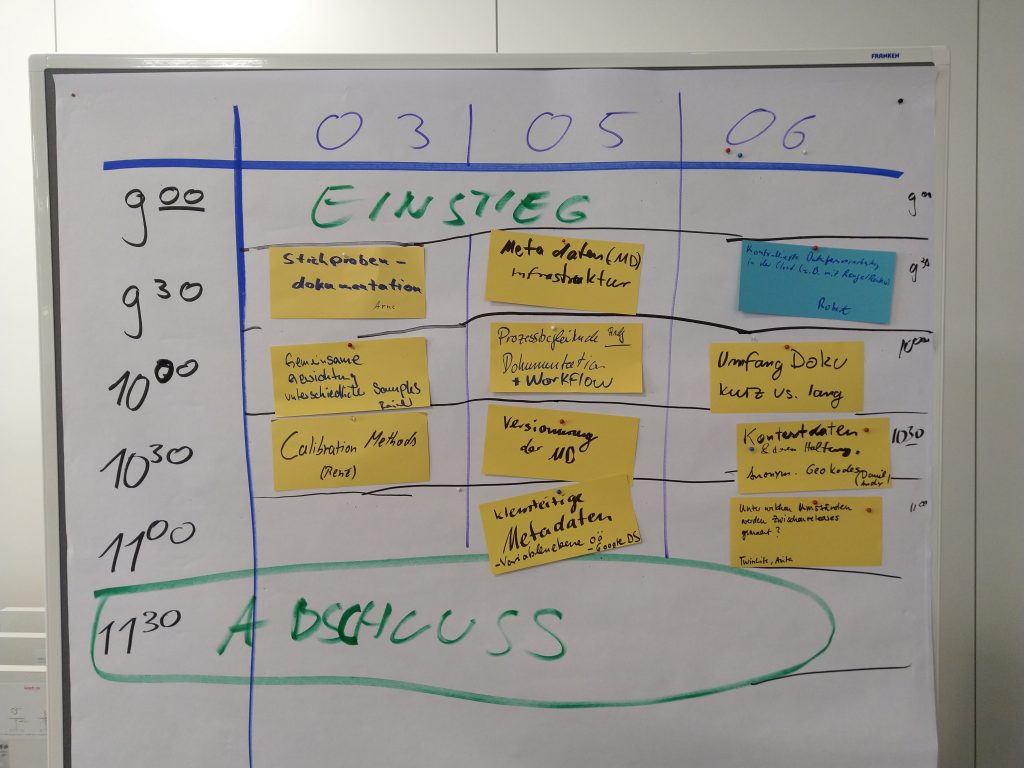

Am 26. August 2019 findet von 11 bis 16 Uhr in den Räumen des DIW Berlin ein weiteres Treffen zur Entwicklung einer Leitlinie zur Datenplausibilisierung statt.

Die Enwicklung einer solchen (bislang fehlenden) Leitlinie wurde auf dem Workshop „Datenaufbereitung und Dokumentation“ 2017 initiert. Das Treffen am 26. August schließt an eine 2018 durchgeführte Erhebung der Plausibilisierungspraktiken bei 10 großen Forschungsinstituten (u.a. SOEP und DZHW) sowie ein erstes Austauschtreffen zu den aktuellen Plausibilisierungspraktiken im Herbst 2018 (und einer weiteren Arbeitsgruppe auf dem Workshop „Datenaufbereitung und Dokumentation“ 2018) an und hat das Ziel einen Vorschlag für eine Leitlinie zur Datenplausibilisierung zu entwickeln.

Zu dem Treffen sind explizit auch an der Mitarbeit interessierte Kolleg*innen eingeladen, die sich gerade mit dem Thema beschäftigen und an den bisherigen Treffen nicht teilnehmen konnten.

Wir freuen uns über eine kurze Rückmeldungen bis zum 23.8. und verbleiben mit Grüßen aus Berlin und Hannover

Andreas (Franken) vom FDZ SOEP sowie Andreas (Daniel) und Percy (Scheller) vom FDZ-DZHW

.jpg)